En el vertiginoso mundo digital actual, la ciberseguridad se ha vuelto más crucial que nunca. La inteligencia artificial (IA) se presenta como un aliado poderoso en esta batalla, ofreciendo innovadoras formas de fortalecer nuestras defensas en línea. En este artículo exploraremos las 5 formas de utilizar la IA en Ciberseguridad para brindarte conocimientos sólidos y estratégicos.

Te puede interesar: Máster en Ciberseguridad

Índice de contenidos

El uso de la Inteligencia Artificial en Ciberseguridad

La utilización de la inteligencia artificial (IA) en ciberseguridad marca un hito crucial en la defensa contra las amenazas digitales. La IA no solo fortalece la capacidad de detección de vulnerabilidades, sino que también revoluciona la rapidez con la que se abordan las amenazas emergentes. Al implementar algoritmos avanzados, la IA analiza patrones de comportamiento en tiempo real, identificando actividades sospechosas y anticipando posibles ataques. Esta tecnología va más allá de la reactividad tradicional, brindando una protección proactiva al aprender de forma continua y adaptarse a las tácticas cambiantes de los ciberdelincuentes. La IA en ciberseguridad se convierte así en una aliada indispensable, proporcionando una capa adicional de seguridad necesaria en la era digital en constante evolución.

Usos de la Inteligencia Artificial en Diferentes Sectores

Formas de utilizar la IA en Ciberseguridad

Reforzando firewalls con Inteligencia Artificial

En un mundo donde los ataques cibernéticos son cada vez más sofisticados, la integración de la IA en los firewalls es esencial. La IA puede analizar patrones de tráfico en tiempo real, identificando comportamientos anómalos y bloqueando posibles amenazas antes de que causen daño.

La IA transforma la funcionalidad estática de los firewalls tradicionales, dotándolos de una capacidad predictiva incomparable. Al analizar continuamente los patrones de tráfico en tiempo real, la IA identifica desviaciones sutiles que podrían indicar un ataque inminente. Esta capacidad de detección proactiva permite bloquear amenazas antes de que alcancen su objetivo, proporcionando una primera línea de defensa robusta y adaptativa contra los cada vez más astutos adversarios cibernéticos.

Detección proactiva de amenazas en tiempo real

La IA permite una detección temprana de amenazas al analizar constantemente la actividad de la red. Detecta patrones sospechosos y comportamientos anómalos, lo que posibilita una respuesta inmediata y eficiente ante posibles ataques, minimizando el tiempo de exposición a vulnerabilidades.

Optimización de la respuesta a incidentes

Al utilizar la IA en la gestión de incidentes de seguridad, las organizaciones pueden acelerar la identificación y resolución de problemas. La automatización de procesos rutinarios libera recursos humanos para abordar desafíos más complejos.

Además, se establece una línea de defensa ágil y robusta, preparada para enfrentar los desafíos de seguridad digital en constante evolución.

Máster en Ciberseguridad

Conviértete en experto en ciberseguridad, un profesional imprescindible para las empresas

¡Quiero saber más!

Análisis predictivo para identificar vulnerabilidades

La IA no solo reacciona ante amenazas conocidas, sino que también realiza análisis predictivos para identificar posibles vulnerabilidades. Esto permite implementar medidas preventivas antes de que los ciberdelincuentes las exploten. La IA examina patrones históricos y comportamientos del sistema, identificando áreas propensas a vulnerabilidades potenciales.

Entrenamiento continuo del sistema de defensa

La IA aprende y evoluciona constantemente. Implementar sistemas de aprendizaje automático permite un entrenamiento continuo del sistema de defensa, adaptándose a nuevas amenazas y garantizando una protección robusta.

Si te quieres convertir en un experto en el área de la ciberseguridad, no te pierdas nuestro Máster en Ciberseguridad. En él aprenderás los principios de la seguridad de la información, algunas de las amenazas y vulnerabilidades más comunes o la arquitectura de seguridad, ¡y mucho más!

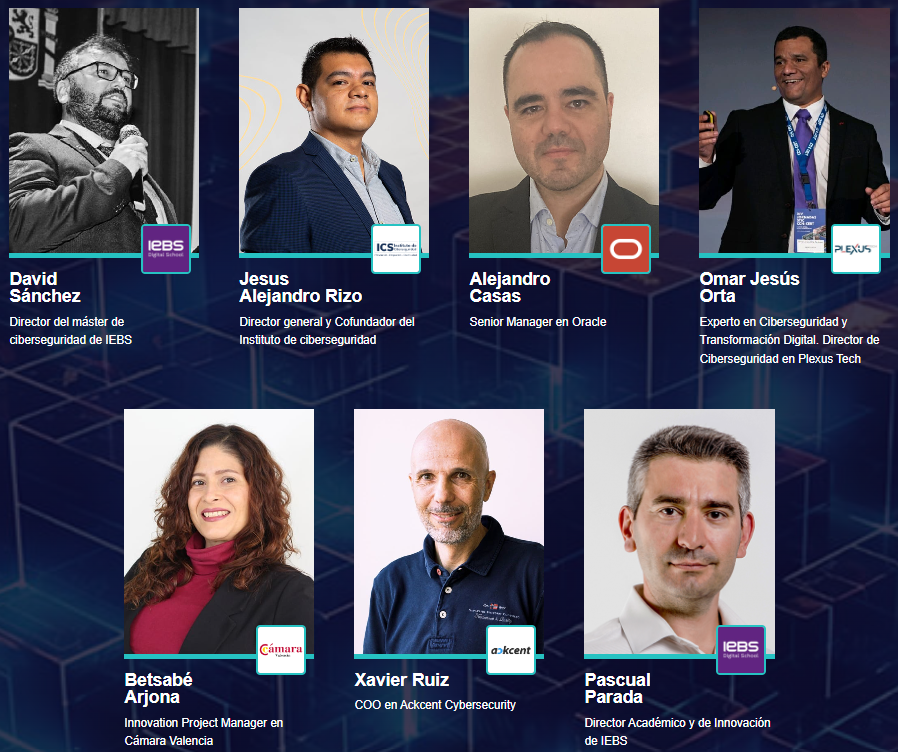

Te recordamos que nuestro evento Cybersecurity Day se celebra mañana a las 18h (ESP). Es un evento totalmente gratuito y online. Contaremos con profesionales de primer nivel como:

No lo dudes más y apúntate a este evento para conocer de la mano de expertos las mejores tácticas para prevenir las amenazas cibernéticas. ¡Te esperamos!

Si has llegado hasta aquí es porque estás al día de las últimas novedades tecnológicas y te interesa protegerte de las amenzas cibernéticas. ¿Qué te ha parecido este artículo? Dejánoslo saber en los comentarios, estaremos encantados de leerte.

Máster en Ciberseguridad

Conviértete en experto en ciberseguridad, un profesional imprescindible para las empresas

¡Quiero saber más!